R语言下的文本挖掘

一些应用都利用了自然语言处理惩罚技能。虽然,统计配景的阐明类科研人员更存眷于舆情阐明这类的文本挖掘技能。

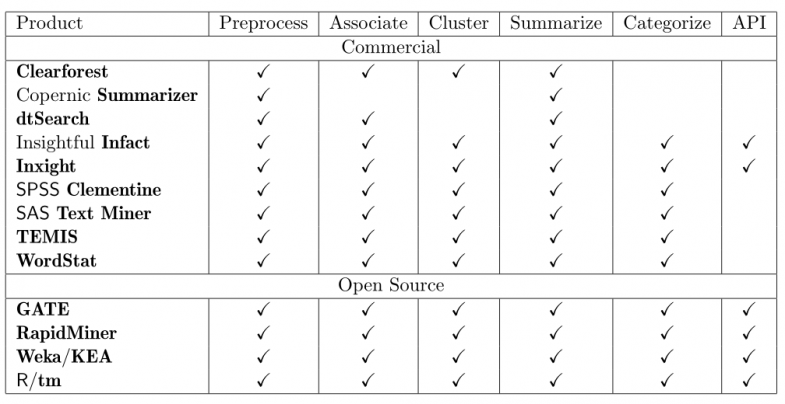

许多统计软件都提供了文本挖掘的成果,好比常见的数据阐明软件SAS、SPSS等,下图是文本挖掘东西及特性的一个总结(来自于Journal of Statistical Software 2008)

至少在2008年,贸易和开源软件的成果特性差不多(但我不确认Latent Semantic Analysis、Latent

对付中文情况下的文本挖掘,无外乎要办理如下几个问题:

在R语言情况下,有浩瀚的包支撑办理上述问题。Ingo Feinerer开拓维护的tm包提供了完整的文本挖掘的框架,借助帮助东西及R包,甚至还可以处理惩罚word、pdf文档的读入,文档处理惩罚并行化运算,文件数据库的语料处理惩罚等问题。

闲话不多说,最下面链接给出了一份基于《Introduction to the tm Package》整理的,基于tm包的中文文本挖掘的先容性文档,内容包括

虽然,作为非正式宣布文档尚有许多处所不尽完善,后续大概会有较大更新,请存眷博客上的to do list。