谈数据中心的最优化节能措施

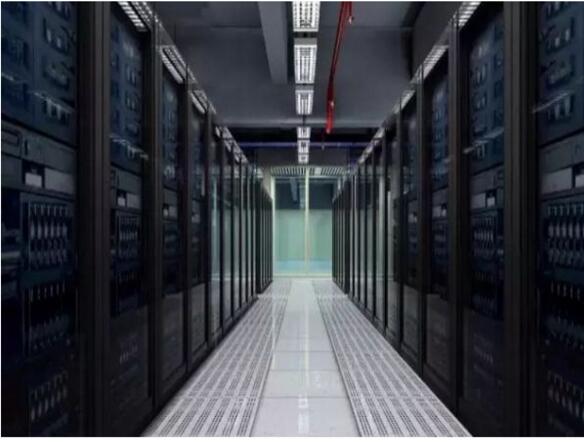

“数据中心是一整套复杂的设施。它不仅仅包括计算机系统和其它与之配套的设备(例如通信和存储系统),还包含冗余的数据通信连接、环境控制设备、监控设备以及各种安全装置”。数据中心解释为“多功能的建筑物,能容纳多个服务器以及通信设备。这些设备被放置在一起是因为它们具有相同的对环境的要求以及物理安全上的需求,并且这样放置便于维护”,而“并不仅仅是一些服务器的集合。

不管你的企业是否已经开始着手数据中心节能,或者根本就没有考虑过这方面的事,你都应该看一看以下列出加强数据中心架构的8个技巧。可能你会惊讶地发现这些技巧实际上都是很简单、不需要太多成本就可以执行的。

不论是大型企业用户还是中小型企业用户都认为能耗是导致成本上涨的最根本原因。市场研究机构Gartner预计,到2011年单是能源成本这一项就要花掉企业将近48%的IT开支,这是一个惊人的比例。

美国环保总署在2007年发布了一份报告中指出,如果能耗目前的水平继续下去的话,到2011年国内数据中心能耗将翻一番。

以下列出了实现高效数据中心的8个重要技巧:

1、不可忽略基本的测量评估有这样一句操作效率的名言:”你无法控制没有经过测量的事物。”我们发现,要想减少能源的浪费就必须从最基本的测量开始。如果你不知道能源都用到了什么地方的话,你就不知道应该将重点方法哪。为了能够帮助用户对自己设备进行测量,我们将测量分成了几个部分:IT系统、供电系统、冷却设备、照明。

2、对IT系统进行虚拟化和整合根据美国环保总署的统计,所有数据中心50%的能源使用都来自于服务器和存储设备。现在服务器虚拟化已经成为主流趋势,这不仅能够减少占地空间,还能节约能源和冷却成本。

为了能够全面了解服务器虚拟化的技术优势,你需要一个提供了整合网络存储的存储架构。服务器虚拟化所能实现的节能同样也可以在存储虚拟化方面实现:更少、更大型的存储系统提供了更大的存储容量、更好的利用率,最终减少占地空间,节约能耗和冷却成本。

通过应用存储和服务器虚拟化,我们就迁移到了一个更加高效的存储模式下。我们用10台最新的存储系统替代了50台已经相当陈旧的存储设备,在这个过程中,我们意识到应用存储和服务器虚拟化有以下一些好处:

存储机架设备从原来的25台缩减到了现在的6台功耗需求从329千瓦降低到了现在的69千瓦空调设备需求降低了94吨支持这些系统设备的电力成本每年节省下60000美元3、管理数据在计划存储虚拟化应用的同时,我们还需要对现有的业务数据进行检查。我们发现已经存储的数据信息中有将近50%都是可以删除掉的。

控制住数据量疯长的一个主要办法就是在最初的阶段阻止数据快速增加。一般企业级磁盘卷可能包含上百万个数据对象。当这些数据对象被修改、分配、备份或者归档之后,数据对象的副本就已经被反复存储了很多遍。

我们采取了重复数据删除、Cloning以及自动精简配置等多种方案途径,目的只有一个,那就是删除不需要的数据。

大多数IT企业机构往往会在冷却系统上花费掉大笔资金。制造企业通常根据自己的能耗水平估算或者工作负载峰值来进行计算的。那么想想看,系统有多少时候是处于负载峰值的情况下工作的?那么你有必要向他们一样对你自己的系统进行冷却吗?

关键是要计算出精确的能源负载,这点不容易做好。为了能够更好的估算出能源负载,我们在将设备配置到数据中心之前还要在实验环境下对这些设备进行测试。通过这些测试,我们可以看出,系统基于功耗负载的测量要比基于上面提到的制造业的测量低30%到40%左右。了解到这一点之后,我们就可以监控每个机架设备的能耗和使用率情况,相应地对冷却系统进行调节,从而减少由于过度冷却而浪费的成本和能源。

但是千万不要就此停止。我们需要进一步适当地调节驱动器风扇的频率。不同工作频率的驱动器风扇转速也有所不同,这主要取决于每个机架需要冷却的程度,实际上我们并不需要让这些风扇时刻以全速进行运转。这些风扇不时地监控温度并自动根据需要减速或者加速运转,这样做可以节省下不少的成本。实际上,风扇速度降低50%就可以相应地减少能耗约87%。

4、考虑数据中心冷却的物理原则这是一个快速的物理循环——热空气上升,冷空气下降。数据中心通产采用的升降板冷却方法会耗费大量的能源。相反,我们可以在设备前面放下一个冷空气的”屏障”,冷空气在设备之间流动,最后排出的热空气上升到屋顶被排到室外。

然而,机架设备的安装非常重要,因为你不希望将一台设备排出的废气引导到另一台设备中。相反,我们会将设备以”面对面”或者”背对背”的方式放置,这种被称为”热通道/冷通道”的排列方法因为其高效率已经成为数据中心的最佳排列方法。

由于我们的冷却系统是处于机架设备上方的,所以我们不需要一个升降地板(通常配置了输送冷水的水管以及冷却通道),这样就节省了不少能源和设备的占地空间。

5、数据中心的物理屏障不论在热通道/冷通道的高密度机架设备是如何放置的,你都需要空气流来防止热废气进入冷空气通道。这时候,我们就需要一个低科技技术来解决这个问题。

当设备排放出上升的热废气时,我们就需要应用一个非常高效、重要的低成本技术。在热通道的末端以及机架设备冷却通风系统上部使用一种聚乙烯基薄膜来隔离热空气——这就像冷冻食品橱中的那样。我们使用这种聚乙烯基薄膜来将热空气圈在热通道内,并且在输送管道和设备之间建立起一个物理屏障。

据我们估计,这种数据中心的物理屏障每年可以节省下100万千瓦的功率。

冷空气并不是冷却系统的唯一途径。为什么不充分利用自然的力量?使用室外空气作为流动的冷却气体,我们每年可以在能源支出上节省150万美元。我们还在系统的一侧安装了节气阀,来自动调节气体的流进和流出。当室外空气温度低于设定温度点时,节气阀打开让室外气体经过空气过滤器流进冷却系统。相反,当室外空气温度上升到设定温度点之上的时候,节气阀关闭并启动空调设备。

这种做法不断被改进,来更好地对冷却系统进行调节。多亏有了我们的环境工程师,我们才能充分地利用室外空气这个免费资源。最初我们将温度设定在11摄氏度,然后逐渐提高到18摄氏度。不久我们还会把温度提高到24摄氏度,这样全年使用室外自由空气来对系统进行冷却的时间就占到了总时间的85%.

6、将电力转换损耗降至最低目前我们的数据中心不再是基于电池设备的系统,而是基于使用可以动态存储能源的**设备。能源来自交换机架构,并被输送到每个**设备中的电力发动机中。飞轮存储的能量可以产生相当于15秒至20秒的能源来保证我们的交换机操作正常进行。老式的电池**和现在最好的**设备的能效分别为85%和94%,而飞轮**的能效可以达到97.7%.能源损耗比电池**少了一半。

7、回收利用热废气随着夏季温度的不断飙升,能源需求和能源成本相应增长。在这个温度和电力高峰时期,我们会使用天然气供能系统来为数据中心提供能源。

第一,配电网安装的在用户处或其附近的小型发电机组坐落在用户附近使得负荷的供电可靠性及电能质量都得到增强,这种被称为”分布式发电”的方法可以削减能源成本、减少在转换过程中的电力损耗。

第二个特点就是利用废热发电。这种方法利用在发电过程中产生的大量热能。我们在一座数据中心中使用天然气发电机产生的热能来为吸收式冷却机提供能源,我们的废热发电系统能效在75%到85%之间,每年能节省大约300000美元的资金。

8、随时监控、随时调节另一个可以提高数据中心效率的做法就是精确地、随时地对环境进行监控。大多数数据中心以规模来计算工作负载,显然有一些情况是不可预测的。为了真正实现高效率,基于每台机架的检测十分重要,而不是当数据中心某个范围温度增高的时候就启动风扇工作。我们经常对我们的设备环境进行测试和调节,多部温度感应器平均可以测量出10到12摄氏度的温差。

#p#分页标题#e#

总结:(1)在数据中心机房中建设冷通道,并配置下送风机房专用风冷式精密空调。

(2)在数据中心机房中建设热通道,并配置下送风机房专用风冷式精密空调。

(3)在数据中心机房中建设专用风冷式精密空调冷风和热风管道,对机柜进行全密封强制散热。

(4)在数据中心机房中使用下送风机房专用风冷式精密空调和智能送风机柜,将机房冷风净压仓的冷风直接送入机柜。

(5)在数据中心机房采用大型水冷式机房精密空调。

(6)在数据中心机房建设专用大型水冷式机房精密空调和芯片冷却管道,直接给IT设备芯片散热。

(7)在数据中心机房采用机房风冷式精密空调+大型新风机1:1配置。

从以上任一种类IDC常态节能措施分析来看,都并非最佳方案。具体分析如下:

从冷源方面说,第1、2、3、4种均都是采用机房专用风冷式精密空调作为冷源,第5、6种采用水冷式精密空调,第7种采用风冷式精密空调或自然冷风和水模。

使用风冷式精密空调在节约电能上主要依靠空调的制冷能效比,能效比在3-4之间,节能方面有限;使用水冷式精密空调,能效比最大能达到6,一般在4以上;使用自然风的新风节系统时,最大能效比可达12。

机房设备制冷效果第1、2、5、7种都采用冷风源被动平均分布散热,要求整个机房的发热量布局要非常均衡,否则可能出现机房冷热不均,单相机柜局部过热的问题。

第3种采用主动大风量强制散热,每个机柜热出风管道都配有风机,散热效果好,容易出现过度制冷,风机也需要消耗一定的电能。

第4种采用主要设备机柜进风口配置变速风机,动态给机柜提供冷风,较好解决局部单个机柜过热和机柜内热负荷突然增大的问题,将机房内温度提高到空调的回风温度,但机柜的深度比普通机柜深度要大100㎡,风机需要消耗电能。

第5种,水冷空调的建设门槛较高,比较适用于大型的机房,空调设备比风冷式精密空调要复杂,成本相对要高一些,运行也需要专业维护人员。

第6种,空调部份和第5种一样,但是分支制冷管道方面,会相对复杂很多,要非常了解服务器产商等设备的结构,甚至于需要它们的支持,成本方面相对会高出一部份。

第7种,空调1:1配置

#p#分页标题#e#

小结:成功设计并建造了低能耗、耐高温、高密集度服务器集群,高承重机架,数据中心外气导入系统和内部气体环流控温系统;实现了以自然冷源替代传统空调设备维持数据机房温湿度,并不是所有的数据中心都可以应用同一个准则。

在保证数据中心连续、可靠运行的同时,数据中心的能耗自然就会显著降低。如何应用一个数据中心节能的策略取决于你的实际情况。本文列出的8个技巧可以给你一些建议,决定应用适合自己的技术来将数据中心效率项目付诸行动。大家都了解到了吗!更多内容就在课课家哟~